telegeram安卓下载中文版

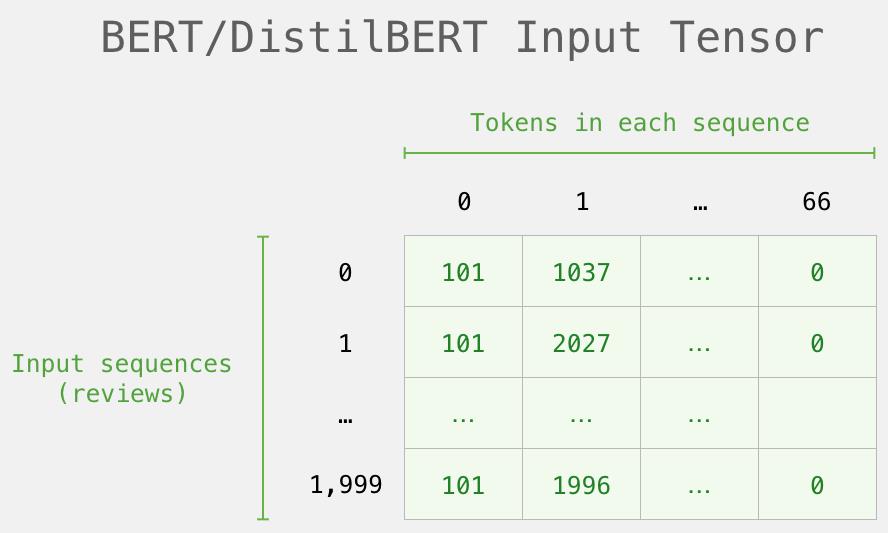

tokenizer.encode参数含义,token o in json at position

1、alist小雅替换token如下1首先,我们使用tokenizer的encode方法将句子转换为一个token序列,其中add_special_tokens=False表示不添加特殊的起始和结束标记2然后,我们使用tokenizer的convert_tokens_to_ids方法将新的token转。

2、input_ids=tokenizerencodeprompt,return_tensors=#39pt#39output=modelgenerateinput_ids,max_length=50,do_sample=Truegenerated_text=tokenizerdecodeoutput0,skip_special_tokens=Trueprintgenerated_text```情。

3、defgenerateself,prompt,length=50,temperature=10input_ids=promptinput_ids=torchtensorinput_ids,dtype=torchlong,device=selfdeviceunsqueeze0withtorchno_gradoutputs=。

4、Elasticsearch 索引的配置项主要分为静态配置属性和动态配置属性,静态配置属性是索引创建后不能修改,而动态配置属性则可以随时修改索引设置 es 索引设置的 api 为 _settings,完整的示例如下PUT my_index quotsettingsquot。

5、prompt_text = quot电视帮生成相关文章的提示语句quot # 将输入文本转换为模型可接受的格式 input_ids = tokenizerencodeprompt_text, return_tensors=quotptquot # 生成文章 output = modelgenerateinput_ids。

6、StringTokenizerString s, String dilim为字符串s构造一个分析器参数dilim中的字符被作为分隔符把StringTokenizer对象称作一个字符串分析器一个分析器可以使用nextToken方法逐个获取字符串中的语言符号单词,每当。

7、tokenizerencodetarget_line, add_special_tokens=True, max_length=max_lengthif leninput_ids max_length or lentarget_ids max。

8、字上下文,这导致了程序崩溃和参数调整2 回答失败虽然用特 开始,都需要执行这些步骤encode 和 decode由于中文不能直。

9、tokenizerencodeinput_text, add_special_tokens=Trueinput_tensors = torchtensorinput_ids# Make the model predictionoutputs =。

10、tokenizerencodesentence_value, add_special_tokens=False label = copydeepcopysentence_ids if sentence_from != 'human' else。

11、tokenizerbatch_encode_plustrain_, max_length=128, padding=True, truncation=True# 将数据包装成 PyTorch。

12、tokenizerencodequestion, return_tensors='pt'to outputs = actorgenerateinput_ids, max_length=max_。

13、tokenizerbatch_encode_plusx_valtolist, max_length = 250, pad_to_max_length=True, truncation=True分词器返回一个字典,其中。

14、Tokenizer 是否可以对该汉字进行 encode 来判断判定的依据也很有意思,设定了几条原则如果模型对该汉字的编码结果为空,模。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~